Будет ли динамичный robots.txt файл, запрещающий обход в зависимости от времени суток, вредит SEO?

У нас серьезная проблема с трафиком на нашем сайте, и мы хотим устранить поисковые роботы как часть этой проблемы. Если мы запретим обход с помощью robots.txt только в течение нескольких часов это повредит нашему SEO?

1 answers

Сосредоточьте свою энергию на улучшении вашего сайта/сервера вместо того, чтобы пытаться найти какой-то хитрый обходной путь. Вы никогда не знаете, в какое время суток поисковые системы будут сканировать ваш сайт, поэтому разрешение их только в определенные окна может оказать сильное негативное влияние. Если вы заблокируете поисковые роботы, когда появится Google, вам не понравятся результаты.

Что вы можете сделать для Google, так это установить скорость обхода . Ограничение скорости обхода ("сколько запросов в секунду Googlebot делает на ваш сайт во время обхода это: например, 5 запросов в секунду") поможет снизить нагрузку, не блокируя их полностью. Если у вас большой сайт, это может означать более длительную задержку до индексации новых обновлений, но это лучше, чем полностью отказаться.

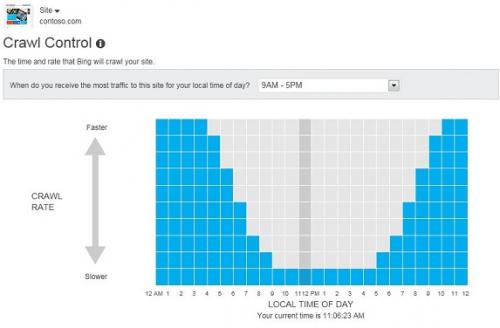

По крайней мере, для Bing у вас есть немного больше контроля. В соответствии с их как на странице:

Вы можете сказать Bingbot, чтобы он сканировал ваш сайт быстрее или медленнее, чем обычная скорость сканирования в течение каждого из 24 часов в сутки. Таким образом вы можете ограничить активность Bingbot, когда ваши посетители находятся на вашем сайте, и предоставить нам больше пропускной способности в более тихие часы.